Relevancia Estratégica y Humana (La Visión Kybernet)

Este paper es fundamental para nuestra biblioteca porque aborda el terreno filosófico (“solidario y humano”, “no hacer daño”) que es el punto de partida de Kybernet. Su valor para nosotros, sin embargo, no reside en sus conclusiones, sino en sus limitaciones, que nos permiten demostrar por qué una visión multidimensional y sistémica es indispensable.

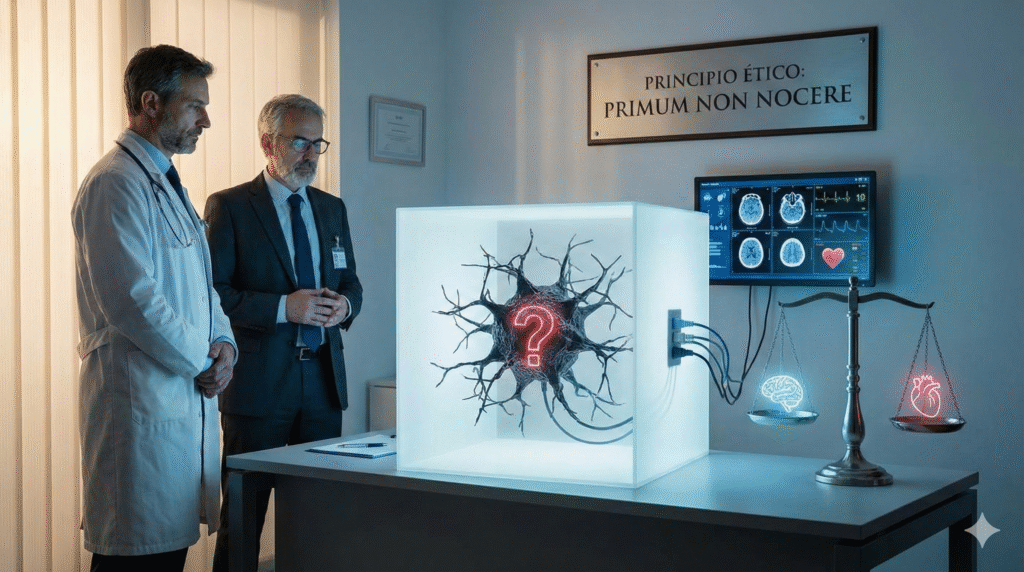

El paper nos sitúa frente a un debate ético crucial: ¿Es aceptable un sistema de IA “caja negra” (incomprensible) en medicina? Los autores argumentan que, desde el principio ético “no hacer daño”, la inexplicabilidad es un riesgo de daño potencial que erosiona la agencia del médico y la autonomía del paciente.

Para Kybernet, este argumento es un punto de partida valioso, pero incompleto. Identifica correctamente principios clave que deben protegerse:

- Defensa de la Agencia Humana: Si un médico no puede entender por qué la IA sugiere un tratamiento, no puede ejercer su juicio profesional. Esto destruye la relación de confianza médico-paciente.

- La Explicabilidad (XAI) como Principio Ético, no Técnico: Este estudio nos impulsa a tratar la “Inteligencia Artificial Explicable” (XAI) no como una característica “deseable”, sino como un requisito ético no negociable en sistemas de alto impacto.

- Alineación con el “Cuidado Mutuo”: Un sistema “caja negra” deshumaniza la medicina al interponer una autoridad opaca. Un sistema explicable, en cambio, actúa como una verdadera herramienta de aumentación, preservando el núcleo humano del acto médico.

El Límite del Análisis: La Tensión entre Ética Individual y Acceso Colectivo

Sin embargo, aquí es donde nuestra visión “multidimensional” diverge críticamente del paper. Su análisis parte de una definición incompleta del “daño”.

Su enfoque es puramente deontológico (basado en el deber individual). Pondera el riesgo ético potencial de la opacidad individual, pero ignora el daño masivo y existente del costo humano de la inaccesibilidad a la salud. Desde nuestra metodología de “Comprensión y Escucha Activa”, este paper es un ejemplo de un análisis que, aunque valioso, solo “escucha” una parte del problema (el riesgo individual), fallando en “comprender” el contexto completo (la necesidad colectiva).

La insistencia en una explicabilidad total puede ser un lujo frente al desafío de la salud pública global. Por ello, ponemos este estudio en diálogo crítico con dos perspectivas complementarias que analizaremos por separado:

- La Justificación Sistémica (Política Pública): ¿Cómo responde la IA a un problema social masivo? Esto lo aborda el paper fundacional de Kong et al. (2019), “Artificial intelligence: a key to relieve China’s insufficient and unequally-distributed medical resources”. Este estudio clave, publicado mucho antes de la explosión de los LLMs, sentó las bases para la política pública china en salud digital (análisis próximamente).

- La Implementación Práctica (Realidad Industrial): ¿Cómo se gestionan los riesgos éticos en la implementación real y actual? Esto lo explora el paper de Chen & Zhang (2025), “DeepSeek reshaping healthcare in China’s tertiary hospitals”, que estudia la aplicación práctica de estas políticas en el sistema público de salud (análisis próximamente).

Para Kybernet, la verdadera estrategia no es elegir entre ética y eficiencia, sino actuar como el articulador que diseña la síntesis: aquella donde la implementación práctica (Chen & Zhang) responde a una necesidad social (Kong et al.) integrando los principios éticos fundamentales (Xu & Shuttleworth) como requisitos de diseño, no como barreras.